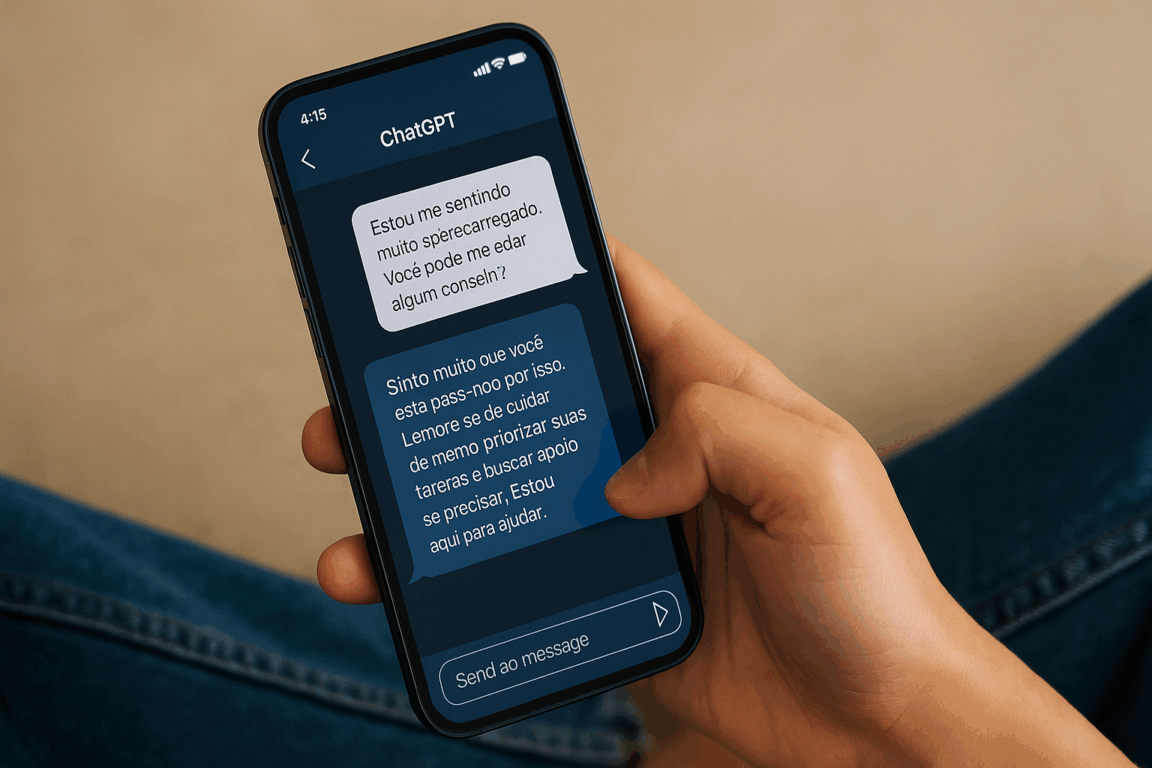

Você já sentiu vontade de falar tudo para alguém, mas não tinha com quem? Recorrer ao ChatGPT pode parecer uma solução prática para aliviar o peso emocional do dia a dia. Na internet, não faltam relatos de usuários dizendo que “fizeram terapia com o robô”, com prints mostrando conversas em que desabafam, pedem conselhos ou até recebem “diagnósticos” do chatbot.

Apesar do tom bem-humorado ou casual dessas publicações, especialistas como a psicóloga Izabella Melo, do Centro Universitário de Brasília (CEUB), alertam para os riscos dessa “terapia digital”. Segundo ela, a inteligência artificial pode gerar uma falsa sensação de alívio, mas não resolve o problema de verdade. “Parece até mágica: você escreve, o robô responde e a dor parece diminuir. Mas isso não é terapia, é só catarse – aquele suspiro de alívio depois do choro”, afirmou.

A psicóloga observa que muitos usuários tentam transformar o chatbot em um “terapeuta de estimação”, mesmo sabendo que ele não substitui um profissional. Outros, que já fazem terapia, usam a IA como confidente nas madrugadas. “Pode ajudar a organizar ideias e colocar sentimentos para fora, mas nunca substitui a escuta qualificada de um terapeuta”, reforçou.

Onde está o problema?

Para a profissional, um dos grandes problemas é que a IA não impõe limites, algo essencial na terapia. “O terapeuta acolhe, mas também provoca, questiona. Esse desconforto é que gera crescimento. O robô, por outro lado, foi feito para agradar e reforçar o que te deixa confortável”, explicou Izabella.

Além disso, segundo a profissional, a segurança dos dados compartilhados é preocupante. Diferente do consultório, onde há sigilo, não se sabe quem acessa ou lucra com as informações passadas às IAs.

Izabella também alerta para os preconceitos embutidos nas respostas da IA, que podem reproduzir discursos discriminatórios, causando danos a quem busca apoio. “Imagine uma adolescente buscando ajuda para entender sua sexualidade e recebendo respostas preconceituosas. Quem se responsabiliza por isso?”, questionou.

Outro risco é o “efeito oráculo”, quando o usuário busca respostas mágicas da IA, acreditando que ela é neutra e sábia. “Mas IA é feita por humanos – e humanos erram”, lembrou a psicóloga.

CONTINUA DEPOIS DA PUBLICIDADE

Para Izabella Melo, a tecnologia pode ajudar em tarefas simples, mas jamais substituirá a escuta empática e o olhar atento do terapeuta. “Tirar uma mochila pesada das costas é só o começo. Depois, é preciso entender o que carregamos dentro dela — e isso a IA não faz”, finalizou.